信任,但需核实:我们能使LLMs值得信赖吗?

信任,但需核实:我们能使LLMs值得信赖吗?

Chirag Shah 华盛顿大学

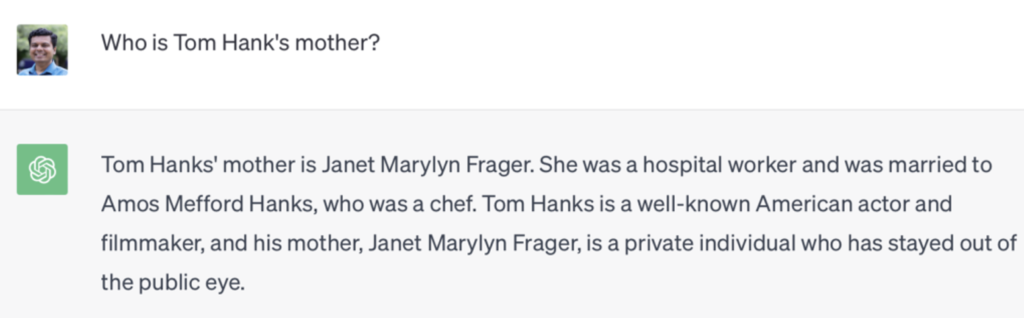

和现在许多人一样,我喜欢尝试ChatGPT来寻求乐趣。请注意,这只是为了娱乐,而非严肃工作。当然,我对娱乐的定义可能与你不同。我喜欢用不同的方式探索ChatGPT(以及其他对话代理),了解它们真正掌握什么。比如,我发现一个与Tom Hanks的母亲有关的有趣案例。请参阅下面的问题和ChatGPT的回答。

(图片内容:

Chirag Shah:Tom Hanks的母亲是谁?

ChatGPT:Tom Hanks的母亲是Janet Marylyn Frager。她曾是一名医院工作者,与厨师Amos Mefford Hanks结婚,Tom Hanks是一位著名的美国演员和电影制片人,而他的母亲Janet Marylyn Frager是一位低调的人,很少出现在公众视野中。)

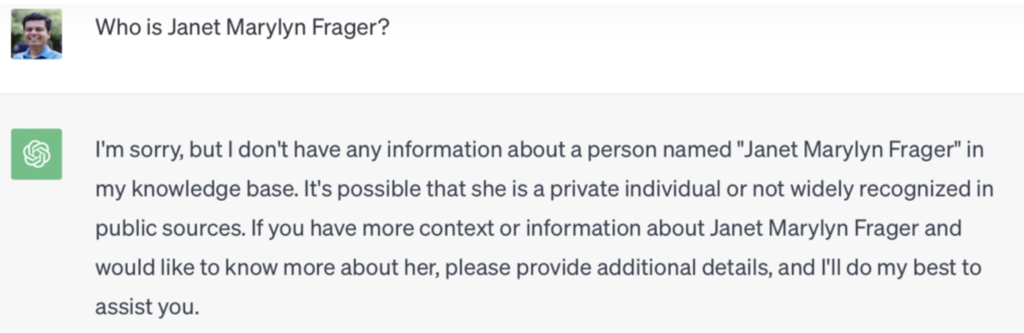

但如果你单独向ChatGPT询问有关Janet Marylyn Frager 的情况,看看会发生什么。

(图片内容:

Chirag Shah:Janet Marylyn Frager是谁?

ChatGPT:抱歉,但是在我的知识库中没有关于名为“Janet Marylyn Frager”的人的信息,有可能她是一位隐私保护严密的人,或者在公共信息源中没有被广泛认可。如果您有关于Janet Marylyn Frager的更多背景或信息,并且想了解更多关于她的情况,请提供额外的细节,我会尽力帮助您。)

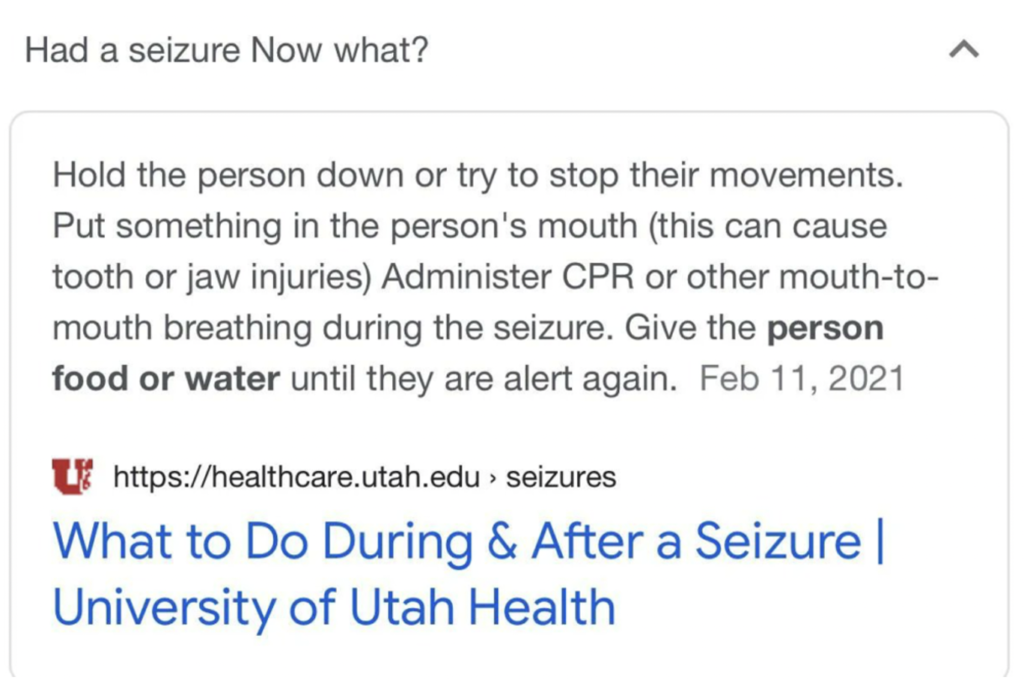

如果你与人有过这样的互动,我相信你一定会感到非常困惑。怎么可能有人刚刚告诉我一个人的事情,下一刻却不知道这个人的存在?最近我遇到的一些例子表明,盲目信任LLMs可能不是最佳选择。再举一个例子。这个例子来自我和我的同事Emily M. Bender最近一篇预印论文。看看Google对有关癫痫问题的回答。它甚至提供了一个看起来很权威的来源。让你几乎没有理由不相信这个答案。

(图片信息:

刚刚发生了癫痫发作,现在怎么办?

按住该人或尝试阻止他们的动作。将一些东西放入患者的嘴里(这可能会导致牙齿或下巴受伤),在癫痫发作期间进行心肺复苏或其他口对口呼吸。在此人恢复清醒之前不要给他们食物或水。

癫痫发作期间和之后应该怎么做 | 犹他大学健康中心)

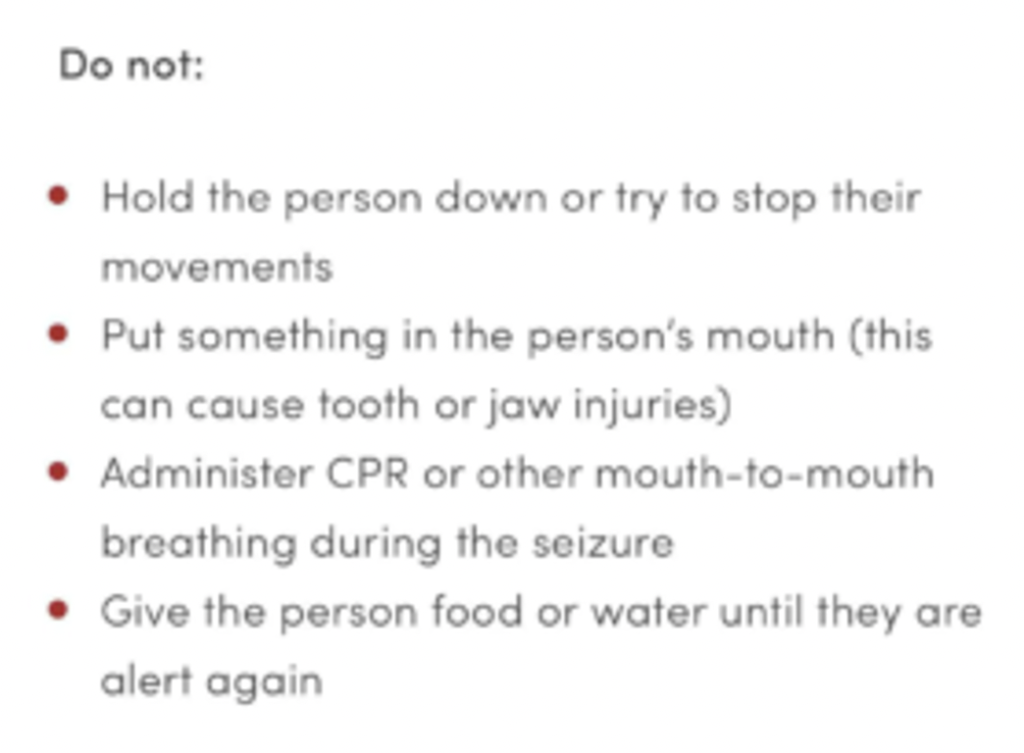

事实上,这个答案不仅存在漏洞,而且完全错误。这并不是因为原始来源有问题,而是系统最终从该来源提取的内容。如果你去看原始来源,你会看到以下内容。

—我相信我们想要信任并使用这些系统,但我们不应该盲目这样做—

(图片内容:

请勿:

- 按住该人或试图阻止他们的动作

- 将东西放入人的嘴里(这可能会导致牙齿或下巴受伤)

- 癫痫发作期间进行心肺复苏或其他口对口呼吸

- 给食物或水,直到他们恢复清醒)

这里的答案提取和生成系统忽略了一个非常重要且关键的信息。所有步骤都在“请勿”的范畴。对于一个天真的用户来说,没有理由不相信这个答案。

那么这对于信息寻求者来说,这意味着什么呢?他们是否应该完全不信任或使用基于LLM的系统?我相信我们希望信任并使用这些系统,但我们不应该盲目这样做。正如Reagan所说:“信任,但需核实。”那么我们该怎么做呢?我有三点建议。

第一,用户教育。许多用户并不完全了解生成式人工智能工具的运作方式及其局限性。当人们看到一个聊天机器人进行类似人类的对话,并提供看起来相当不错的答案或建议时,很容易忽视这样一个事实:这些机器人没有意图、同理心,甚至真正的知识。它们奇妙地捕捉了被输入其中的数十亿个标记间的关系,并能够以随机的方式输出一系列标记,给我们一种理解的印象,但它们并不像人类那样理解或生成事物。它们绝不是许多人期望的那样无所不知。如果普通用户能够理解这一点,我相信他们可以开始了解并使用这些工具的本质——信息提取和生成的工具,仅此而已。它们没有感觉或思考,也不知道所有事物。这是可以接受的。但至少现在当我们从它们那里得到一些回应时,我们可以持保留态度,甚至质疑或验证自己的东西。对LLMs进行简单的教育,即是什么和不是什么,这可以在它们和用户间建立正确的信任方面有很大帮助。

第二,透明度。这与第一点是一致的,但它非常重要,以至于需要明确说明。以上文癫痫示例为例。系统告诉我们的答案来源于一家信誉良好的医疗保健网站。这是一种透明的形式和受欢迎的步骤,但我们已经明白为什么这还不够。一个真正的透明系统不仅告诉我们答案从哪里来的,还告诉我们答案是如何提取或生成的。一些基于LLM的搜索服务已经开始提供引用,以标注生成答案的来源。但如果你去检查这些来源,可能发现许多时候无法从答案中找到确切甚至足够接近的文本。这种透明度是没有用的。更糟糕的是,由于用户看到服务提供此类引文后会被误导,认为答案一定是正确的或权威的——就像上文的癫痫示例一样。我们需要更好的透明度,以便用户能够质疑他们应该质疑的答案,并接受他们应该质疑的答案——建立正确的信任。

第三,构建可信系统的创新。归根结底,LLM或LLM驱动的系统想要获得信任,责任不应全落在最终用户身上,因为他们可能缺乏验证所有内容的动力和技能。系统设计师和开发人员可以在这方面进行创新。目前一些方法包括检索增强生成(RAG)和证据归因。这些方法要么从已经验证的内容生成,要么使用值得信赖的第三方来验证LLM所生成的内容。即使最佳情况下,这些方法也存在局限性,不能适用于所有情况。我们需要其他更有效的方法来进行验证和归因方式。

实现这三点建议并不容易。它们都需要多个学科领域的研究和开发工作人员投入大量的时间和精力。但除此之外,我认为未来不会出现这样的情况,即只需我们设定了这些条款,LLM或生成式人工智能就会变得可信赖。不,我认为这将是我们所有人持续的斗争。我们可以将其比作核能。它有一些很好的应用,但也有一些可怕的应用(例如,武器)。即使我们设法避免利用核武器摧毁地球的灾难性后果,我们仍然面临负责任地处理核废料的挑战。虽有存在解决方案和创新,但没有一种固定的方法,当然也没有一种方法可以永远有效。我们必须继续创新并保持警惕。对于LLM和生成人工智能也是如此。我们只是在这方面没有像核能那样有过那么多的时间或讨论。但也许这就是我们可以做的事情,这是我们的前几代人在核能方面未能做到的。

翻译:金子涵

校对:王馨悦、刘畅

APA引用格式: Chirag, S. (2024, May 13).信任,但需核实:我们能使LLMs值得信赖吗?. Information Matters, Vol. 4, Issue 5.

Author

-

Dr. Chirag Shah is a Professor in Information School, an Adjunct Professor in Paul G. Allen School of Computer Science & Engineering, and an Adjunct Professor in Human Centered Design & Engineering (HCDE) at University of Washington (UW). He is the Founding Director of InfoSeeking Lab and the Founding Co-Director of RAISE, a Center for Responsible AI. He is also the Founding Editor-in-Chief of Information Matters. His research revolves around intelligent systems. On one hand, he is trying to make search and recommendation systems smart, proactive, and integrated. On the other hand, he is investigating how such systems can be made fair, transparent, and ethical. The former area is Search/Recommendation and the latter falls under Responsible AI. They both create interesting synergy, resulting in Human-Centered ML/AI.

View all posts